deepseek部署的详细步骤和方法(部署教程)

使用Ollama本地部署DeepSeek R1模型:从零到精通的完整指南

DeepSeek R1是由中国人工智能公司深度求索(DeepSeek)推出的高性能开源模型deepseek部署的详细步骤和方法,其推理能力接近GPT-4 Turbo,且支持本地部署,兼顾数据隐私与成本效益。本教程将详细介绍如何通过Ollama工具在本地设备上部署DeepSeek R1模型,并优化其性能与交互体验。

一、DeepSeek R1的核心优势 高性能推理

R1系列模型(1.5B至671B参数)在数学、代码生成及自然语言任务中表现优异,32B及以上版本支持多步骤逻辑推理(Chain-of-Thought),效果接近闭源模型如GPT-4。开源与商用友好

采用MIT协议deepseek部署的详细步骤和方法,支持自由修改与商业应用,同时提供模型蒸馏技术,适配低资源场景。硬件兼容性

从消费级显卡(如RTX 3060)到企业级GPU(如A100)均支持,显存需求覆盖8GB至48GB,内存建议16GB起步。 二、部署前的准备工作 1. 硬件与系统要求 内存:16GB(7B模型)至64GB(32B及以上模型)。系统:支持Windows、macOS、Linux,推荐使用Docker简化环境配置。 2. 安装Ollama

Ollama是本地运行大模型的核心工具,支持一键安装:

三、模型部署与运行 1. 下载DeepSeek R1模型

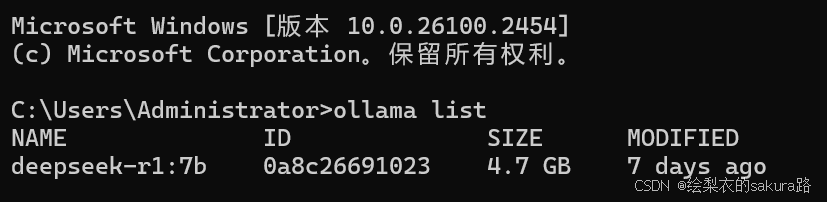

通过Ollama命令行拉取模型(以7B为例):

ollama run deepseek-r1:7b # 自动下载并启动。

2. 配置环境变量(可选) 四、交互界面优化 1. 命令行基础操作

2. 图形化客户端推荐 五、性能优化与高级技巧 1. 加速推理 2. 长文本与隐私场景 六、常见问题与解决方案 问题现象解决方案紧急程度

显存不足

换用量化模型或更小参数版本

⚠️高

响应速度慢

增加OLLAMA_NUM_THREADS值

中

中文夹杂英文

在Prompt末尾添加“请用纯中文”

中

生成内容中断

输入/continue继续生成

✅低

七、应用场景扩展 代码开发:通过R1生成复杂算法(如快速排序),支持Java、Python等语言。多语言翻译:14B及以上模型可处理嵌套JSON文件翻译任务,保留原格式。企业客服:集成至微信作为智能体,提供深度问答服务。

通过Ollama部署DeepSeek R1,用户可在本地低成本实现高性能AI应用。无论是个人学习还是企业级开发,均可通过灵活配置满足需求。未来,结合知识库与多模态扩展,R1的潜力将进一步释放。

文章评论(0)