deepseek部署的详细步骤和方法(uml部署图实验步骤)

DeepSeek 改进大型语言模型推理能力的新方法

DeepSeek 通过强化学习(RL)引入了一种创新方法,以提升大型语言模型(LLMs)的推理能力,这一方法在他们近期发布的论文《DeepSeek-R1》中有详细阐述。这项研究在通过纯强化学习而无需大量监督微调来增强 LLM 解决复杂问题的能力方面,代表了一个重要的进展。

DeepSeek-R1 的技术概述

模型架构:

DeepSeek-R1 不是一个单一的模型deepseek部署的详细步骤和方法,而是一系列模型,包括:DeepSeek-R1-Zero 和 DeepSeek-R1。

让我说明一下 DeepSeek-R1 和 DeepSeek-R1-Zero 之间的关键区别:

主要区别

DeepSeek-R1-Zero 代表团队使用纯强化学习而不进行任何监督微调的初步实验。他们从基础模型开始,直接应用强化学习,让模型通过试错过程发展推理能力。虽然这种方法取得了令人印象深刻的结果(在 AIME 2024 上达到 71% 的准确率),但在可读性和语言一致性方面存在一些显著的限制。该模型拥有 6710 亿个参数,采用混合专家(MoE)架构,每个标记激活相当于 370 亿个参数。这个模型展现出了新兴的推理行为,如自我验证、反思和长链思维(CoT)推理。

相比之下,DeepSeek-R1 使用了更复杂的多阶段训练方法。它不是纯粹依赖强化学习,而是在应用强化学习之前,首先在一小部分经过精心挑选的示例(称为“冷启动数据”)上进行监督微调。这种方法解决了 DeepSeek-R1-Zero 的局限性,同时实现了更好的性能。该模型同样保持了 6710 亿参数,但在响应的可读性和连贯性方面表现更佳。

训练过程比较

训练方法论:

DeepSeek-R1-Zero 的训练过程非常简单:

从基础模型开始

直接应用强化学习

使用基于准确性和格式的简单奖励

DeepSeek-R1 的训练过程则包括四个不同阶段:

使用数千个高质量示例进行初始监督微调

重点针对推理任务进行强化学习

通过拒绝采样收集新的训练数据

在所有类型的任务上进行最终的强化学习

性能指标:

成本效益:DeepSeek-R1 的 API 定价为每百万输入标记 0.14 美元,对于缓存命中,显著低于类似模型如 OpenAI 的 o1。

局限性与未来工作

论文承认了几项需要改进的领域:

未来的工作将重点解决这些限制,并扩展模型在函数调用、多轮交互和复杂角色扮演场景等方面的能力。

部署与可访问性

开源与许可:DeepSeek-R1 及其变体在 MIT 许可下发布,促进了开源合作和商业使用,包括模型蒸馏。此举对于促进创新和降低 AI 模型开发的门槛至关重要。

模型格式:两种模型及其蒸馏版本均提供 GGML、GGUF、GPTQ 和 HF 等格式,允许灵活地在本地部署。

通过 DeepSeek 聊天平台的网页访问

DeepSeek 聊天平台提供了一个用户友好的界面,可以无需任何设置即可与 DeepSeek-R1 互动。

访问步骤:

通过 DeepSeek API 访问

对于编程访问,DeepSeek 提供了与 OpenAI 格式兼容的 API,允许集成到各种应用中。

使用 API 的步骤:

a.获取 API 密钥:

b.配置你的环境:

c.进行 API 调用:

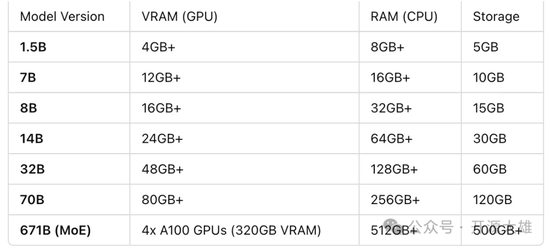

在本地运行 DeepSeek-R1

两种模型(R1 和 R1-Zero):

本地运行的软件工具:

通过 Ollama 向本地下载的 DeepSeek-R1 发送请求:

Ollama 提供了一个 API ,可以以编程方式与 DeepSeek-R1 互动。确保 Ollama 服务器在本地运行后再进行 API 请求。你可以通过运行以下命令启动服务器:

ounter(lineollama serve

服务器启动后,你可以使用 curl 发送请求deepseek部署的详细步骤和方法,如下所示:

ounter(lineounter(lineounter(lineounter(lineounter(linecurl -X POST -d ‘{ “model”: “deepseek-r1”, “prompt”: “你的问题或提示内容”}‘

将“你的问题或提示内容”替换为你希望提供给模型的实际输入。该命令向本地 Ollama 服务器发送一个 POST 请求,服务器使用指定的 DeepSeek-R1 模型处理提示并返回生成的响应。

本地运行/访问模型的其他方法包括:

结论

从 DeepSeek-R1-Zero 到 DeepSeek-R1 的这一进展,代表了研究中的重要学习历程。虽然 DeepSeek-R1-Zero 证明了纯强化学习的可行性,但 DeepSeek-R1 展示了将监督学习与强化学习相结合如何能够创建一个更强大且实用的模型。

海量资讯、精准解读,尽在新浪财经APP

文章评论(0)